Rendre l'IA déterministe dans vos workflows professionnels

Un centre de formation reçoit 150 candidatures pour sa prochaine session "Préparateur en pharmacie". Pour gagner du temps, l'équipe a déployé un workflow IA qui analyse les CV et génère des recommandations : "Convocation entretien", "À étudier", ou "Rejeter".

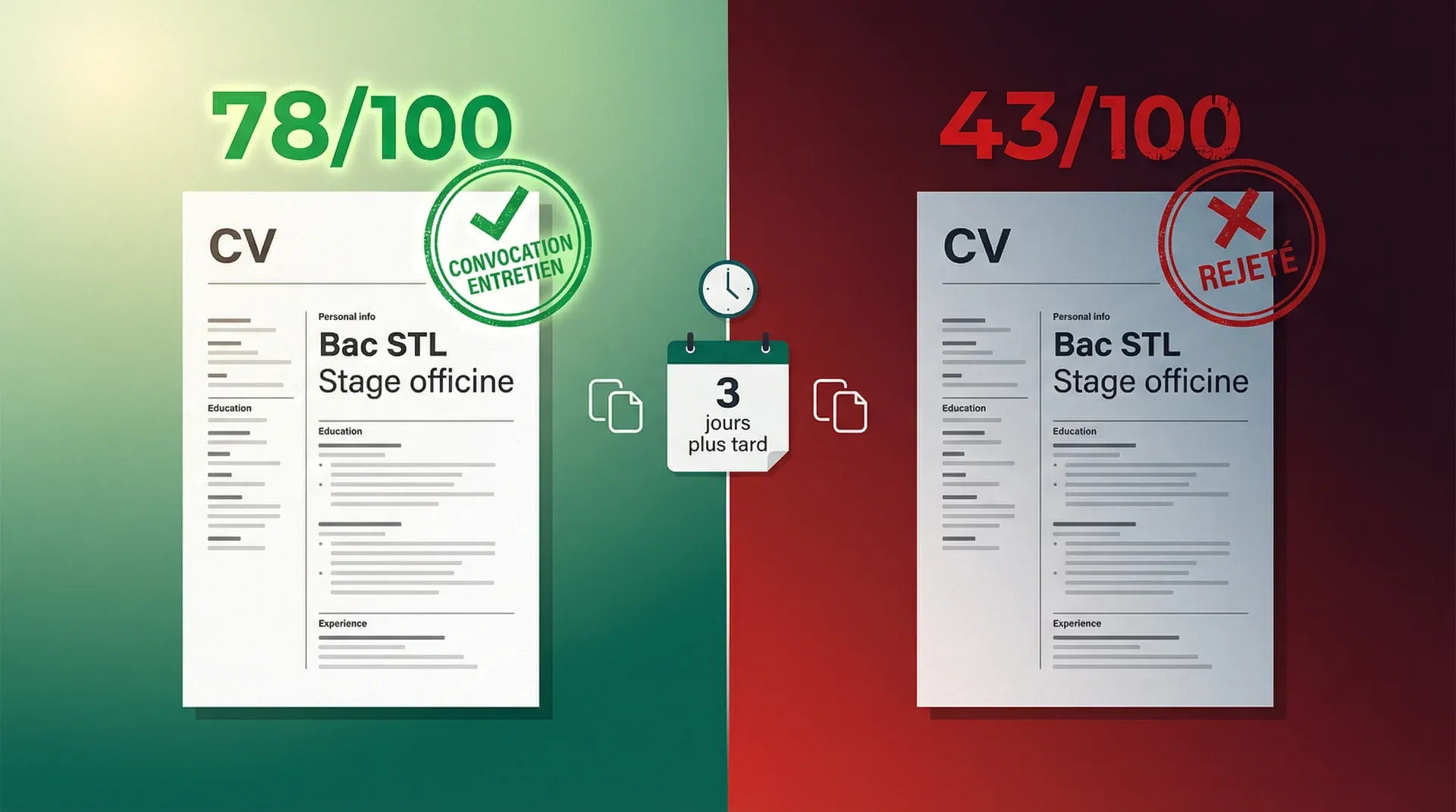

Lundi matin, un candidat postule. Titulaire d'un Bac STL, stage validé en officine. L'IA analyse le dossier et attribue un score de 78/100 avec la recommandation "Convocation entretien". Justification automatique : "Parcours scientifique solide, expérience terrain en officine, motivation claire pour le secteur pharmaceutique."

Quelques jours plus tard, erreur de synchronisation dans le CRM. Le même CV est re-soumis automatiquement au système. Cette fois, l'IA attribue un score de 43/100 avec la recommandation "Rejeter". Nouvelle justification : "Parcours trop générique, manque de spécialisation scientifique, expérience en officine insuffisante."

Même CV. Mêmes critères de formation. Conclusions opposées.

Le responsable pédagogique passe 20 minutes à vérifier manuellement chaque incohérence. Sur 3 mois, l'audit interne révèle que 14% des candidatures montrent des variations de score supérieures à 25 points. Impossible d'identifier un pattern : ce n'est pas lié à l'heure, au jour, ou à la charge serveur.

Le vrai problème apparaît quand un candidat qualifié, rejeté, rappelle le centre pour comprendre pourquoi il a été refusé. Re-soumission manuelle : accepté immédiatement.

Candidat mécontent, temps perdu, confiance érodée.

Le problème n'est pas où vous pensez.

Pourquoi l'IA produit des résultats différents

Les modèles d'IA ne fonctionnent pas comme un tableur Excel. Quand vous entrez une formule dans Excel, vous obtenez toujours le même résultat. L'IA, elle, calcule des probabilités.

Prenez le système du centre de formation. Il envoie le CV à un modèle de langage avec une instruction : "Analyse ce CV et dis-moi si le candidat correspond aux critères". Le modèle examine le texte, évalue plusieurs interprétations possibles, et en choisit une. Mais ce choix contient une part de variabilité.

Vous pouvez réduire cette variabilité en ajustant des paramètres. Mais vous ne pouvez pas l'éliminer complètement. Même quand on force le modèle à être "le plus déterministe possible", des micro-variations subsistent. Elles viennent de l'infrastructure, de l'ordre de traitement des données, des optimisations internes que les fournisseurs de modèles appliquent.

En phase de test, avec 10 ou 20 exemples, vous ne voyez pas le problème. Vous ajustez votre prompt, vous relancez, ça "marche bien".

Mais quand vous passez à 5,000 requêtes par jour en production ?

Les cas limites que vous n'aviez jamais vus apparaissent. Un CV qui se situe juste à la frontière entre "acceptable" et "limite" peut basculer d'un côté ou de l'autre selon l'exécution.

Le passage du prototype à la production change la donne. En démo, on teste jusqu'à ce que ça marche. En production, on subit tous les cas réels, y compris ceux qu'on n'avait pas anticipés.

Utiliser l'IA là où elle apporte vraiment quelque chose

Le vrai problème n'est pas tant la variabilité que le design du workflow. Demander à l'IA de prendre des décisions binaires, c'est se tirer une balle dans le pied.

Les cas où l'IA apporte une vraie valeur :

Analyser une lettre de motivation pour identifier la motivation réelle, l'adéquation culturelle, ou les signaux d'engagement. Ça nécessite une compréhension nuancée du langage. L'IA détecte des patterns subtils : le ton, la cohérence narrative, l'alignement avec les valeurs du métier. Ces évaluations produisent des insights que l'humain peut utiliser pour affiner sa décision. Personne ne demande un oui/non brutal, on cherche des signaux.

Extraire automatiquement les compétences d'un CV, catégoriser des expériences professionnelles, structurer des informations disparates. L'IA transforme du bordel en données exploitables. Cette étape de pre-processing réduit la charge cognitive et accélère le traitement. Mais elle ne remplace pas le jugement final.

Comparer un profil avec un référentiel de compétences, identifier les écarts, suggérer des formations complémentaires, recommander des parcours alternatifs. L'IA croise des milliers de combinaisons et propose des rapprochements non évidents. C'est de l'aide à la décision.

Les cas où l'IA crée plus de problèmes qu'elle n'en résout :

Accepter ou refuser une candidature. Valider ou rejeter un dossier. Ces décisions nécessitent une reproductibilité stricte. Si les critères sont suffisamment clairs pour être automatisés, vous n'avez pas besoin d'IA. Codez vos règles métier en dur. Si les critères ne sont pas assez clairs, l'automatisation est prématurée. Point.

Vérifier qu'un candidat possède un diplôme requis, calculer des années d'expérience, valider la présence d'une certification obligatoire. Ces vérifications sont objectives. Un système à base de règles les traite en millisecondes avec un taux d'erreur nul. Introduire un modèle de langage ajoute de la latence, du coût, et du risque d'erreur. Pour quoi faire ?

Les processus soumis à des obligations de transparence ou de non-discrimination. Le RGPD impose le droit à l'explication. Si vous ne pouvez pas garantir que la même entrée produira la même sortie, vous ne pouvez pas expliquer pourquoi une décision a été prise. Vous êtes en infraction, c'est aussi simple que ça.

Le centre de formation a fait l'erreur classique : utiliser l'IA pour remplacer l'humain sur une décision binaire (convoquer ou rejeter) alors que les critères d'admission sont parfaitement documentés. Bac scientifique requis ? Vérification déterministe. Stage en officine souhaité ? Extraction structurée puis règle métier. Motivation cohérente ? Évaluation qualitative par l'IA, mais décision finale humaine.

Quand vous automatisez mal, vous n'apportez pas d'efficacité. Vous industrialisez le chaos.

Ce que ça coûte vraiment

Chaque candidat rejeté à tort est une opportunité manquée. Dans le cas du centre de formation, un candidat qualifié qui rappelle pour contester son rejet découvre que sa candidature est finalement acceptée. Ce parcours chaotique dégrade l'image du centre. Le bouche-à-oreille local est critique pour les établissements de formation. Un candidat mécontent en parle à 10 personnes. Une session à 20 places avec un taux de remplissage de 85% au lieu de 100% représente une perte sèche de revenus.

À plus grande échelle, le problème s'amplifie. Une entreprise qui traite 10,000 candidatures par an et rejette 2% de profils qualifiés par erreur perd 200 opportunités. Si ces candidats avaient un taux de conversion en employés de 30%, c'est 60 recrutements manqués. Le coût de remplacement d'un employé oscille entre 6 et 9 mois de salaire selon les secteurs.

Le RGPD impose le droit à l'explication pour toute décision automatisée produisant des effets juridiques ou affectant significativement une personne. Un candidat rejeté peut demander les raisons exactes de cette décision. Si votre système produit des justifications différentes pour le même profil, vous ne pouvez pas expliquer. Vous êtes en infraction.

Quand vos équipes internes perdent confiance dans le système qu'elles sont censées utiliser, elles développent des workarounds. Le responsable pédagogique qui vérifie manuellement chaque recommandation de l'IA annule complètement le gain de temps promis. Pire, il ajoute une couche de complexité : maintenant il doit gérer l'outil ET faire le travail manuellement.

Les utilisateurs finaux développent une méfiance envers l'organisation. Un candidat qui constate des incohérences dans le traitement de sa candidature se demande si le centre est professionnel. Cette perception s'étend à la qualité de la formation elle-même. Si l'établissement ne maîtrise pas ses propres processus d'admission, peut-on lui faire confiance pour délivrer une formation de qualité ?

Questions décisionnelles avant mise en production

Avant de déployer un workflow intégrant de l'IA en production, posez-vous ces questions :

Pouvez-vous reproduire exactement la même décision pour le même input ? Si la réponse est non, demandez-vous si cette décision devrait être automatisée. La variabilité peut être acceptable pour de la génération de contenu, elle ne l'est jamais pour des décisions impactant des personnes.

Avez-vous séparé les critères objectifs des évaluations subjectives ? Les critères objectifs (diplôme, années d'expérience, localisation géographique) doivent être traités par des règles déterministes. Seules les évaluations subjectives (motivation, adéquation culturelle, potentiel d'évolution) peuvent justifier l'usage d'un LLM, et encore, uniquement en mode assisté.

Pouvez-vous expliquer à un candidat rejeté pourquoi sa candidature n'a pas été retenue ? Si vous ne pouvez pas garantir que la même explication sera donnée à deux moments différents, votre système n'est pas conforme au RGPD. Et plus important encore, il n'est pas juste.

Que se passe-t-il quand l'IA se trompe ? Avez-vous un processus de contestation ? Combien de temps faut-il pour traiter une anomalie ? Qui est responsable : vous, le fournisseur du modèle, l'éditeur du logiciel ? Répondez à ces questions avant de déployer, pas après le premier incident.

Votre équipe fait-elle confiance au système ou le contourne-t-elle systématiquement ? Si vos opérationnels vérifient manuellement 80% des recommandations de l'IA, vous n'avez pas automatisé le processus, vous l'avez complexifié. C'est un signal que le système n'est pas prêt.

La vraie question n'est pas technique

Le non-déterminisme des modèles de langage n'est pas un bug qu'une mise à jour va corriger. C'est une caractéristique fondamentale de leur architecture. Vouloir rendre un modèle de langage parfaitement déterministe, c'est lutter contre sa nature probabiliste. Autant demander à un dé de toujours tomber sur 6.

Les entreprises qui réussissent leur adoption de l'IA en production ne sont pas celles qui automatisent le plus. Ce sont celles qui conçoivent des workflows où l'IA et l'humain se complètent. L'IA traite le volume, structure l'information, identifie les signaux. L'humain valide, décide, assume.

Quand vous vous demandez si un workflow mérite d'être automatisé avec de l'IA, la variabilité des résultats vous donne la réponse. Si cette variabilité pose problème, c'est que l'automatisation est mal conçue.